Stable Diffusion教程-如何使用VAE来改进眼睛和面部

如何使用VAE来改进眼睛和面部

VAE是对Stable Diffusion 1.4或1.5模型的部分更新,可以使眼睛的渲染效果更好。我将解释什么是VAE,您可以期待什么,您可以从哪里获取它以及如何安装和使用它。

什么是VAE?

VAE代表变分自编码器(variational autoencoder)。它是神经网络模型的一部分,用于将图像从较小的潜在空间进行编码和解码,以便计算速度更快。

我需要VAE吗?

您不需要安装VAE文件来运行Stable Diffusion - 无论您使用的是v1、v2还是自定义模型,它们都已经有一个默认的VAE。

当人们说下载和使用VAE时,他们指的是使用改进版本的VAE。这是在模型训练者使用额外数据对模型的VAE部分进行进一步微调时发生的。他们不会发布一个完全新的模型(这是一个庞大的文件),而只发布已经更新的一个小部分。

使用VAE有什么效果?

通常来说,效果相对较小。改进的VAE能够更好地从潜在空间解码图像。细节恢复得更好。它有助于渲染眼睛和文字,这些地方细节都非常重要。

Stability AI发布了两种经过微调的VAE解码器变体,即EMA和MSE。(指数移动平均和均方误差是衡量自编码器好坏的指标。)

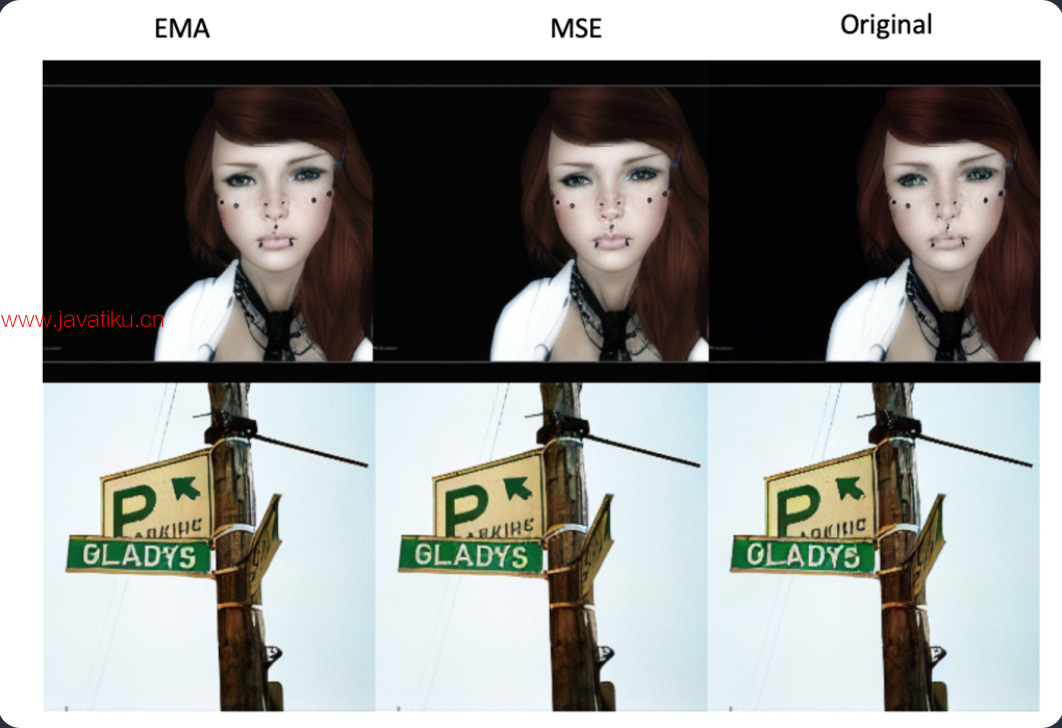

下面是他们的比较:

你应该使用哪个呢?Stability在使用256×256像素图像时的评估是,EMA产生更清晰的图像,而MSE的图像更平滑。(这与我的个人测试结果相符。)

在我个人对Stable Diffusion v1.4和v1.5进行使用512×512像素图像的测试中,我发现在一些图像中,特别是当面部较小时,渲染眼睛方面有明显的改善。我没有看到任何对渲染文本的改进,但无论如何,我认为并不是很多人使用Stable Diffusion来渲染文本。

在任何情况下,新的VAE都不会表现更差。要么有所改进,要么没有改变。

下面是使用Stable Diffusion v1.5模型进行比较的原始图像、EMA和MSE的结果。 (提示可以在此处找到。)放大并比较它们之间的差异。

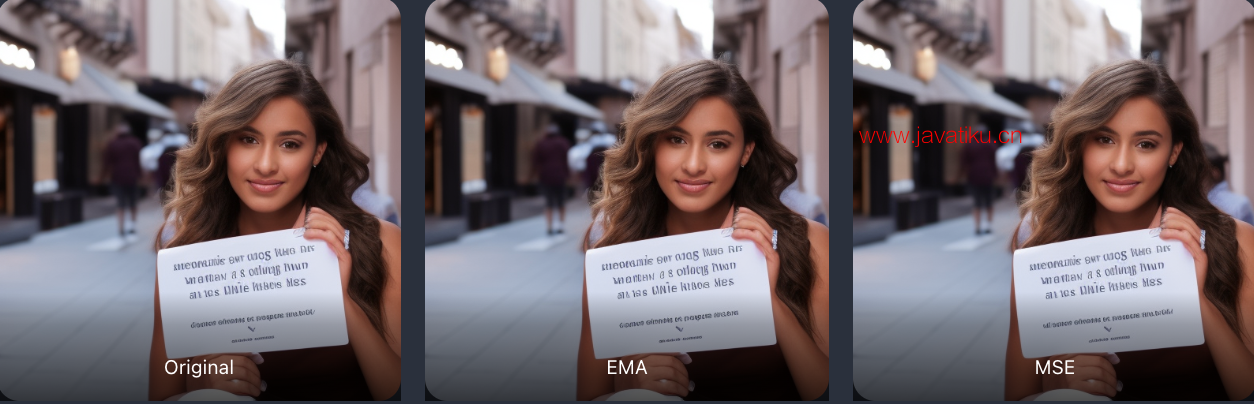

对于文本生成的改进效果不太明显(将“holding a sign said Stable Diffusion”添加到提示中):

您也可以将这些VAE与自定义模型一起使用。我测试过一些动漫模型,但没有看到任何改进。我鼓励您进行自己的测试。

最后说明一下,EMA和MSE与Stable Diffusion v2.0兼容。您可以使用它们,但效果很小。2.0版本在渲染眼睛方面已经非常出色。也许他们已经将这一改进纳入了模型中。

我是否应该使用VAE?

如果您对自己得到的结果感到满意,那么您不需要使用VAE。例如,您已经使用了像CodeFormer这样的人脸修复工具来修复眼睛。

如果您属于尽可能获取所有微小改进的人群,那么您应该使用VAE。您只需要一次性进行设置的麻烦。之后,艺术创作流程保持不变。

如何使用VAE?

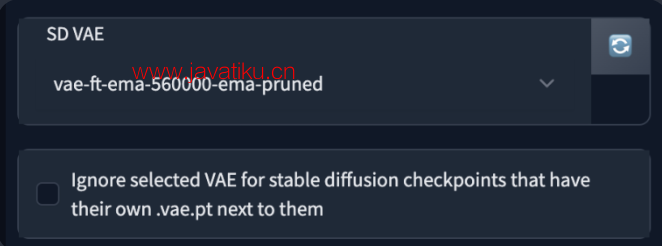

要在AUTOMATIC1111 GUI中使用VAE,请转到“Settings”选项卡,然后在左侧找到“Stabe Diffusion”部分。

找到名为“SD VAE”的部分。在下拉菜单中,选择要使用的VAE文件。

在顶部按下大红色的“Apply Settings”按钮。当加载成功时,您应该在“Setting”选项卡中看到消息。

Settings: sd_vae applied下拉菜单中的其他选项包括:

- None:使用模型自带的原始VAE。

- Auto:请参考此帖子了解其行为。我不建议初学者使用Auto,因为很容易混淆使用的是哪个VAE。

专业提示:如果找不到某个设置,请点击左侧的“Show All Pages”。所有设置将显示在一个页面上。使用Ctrl-F查找设置。